还在「问号脸」?科技陪你「看懂」冰雪赛事 原创

冰雪运动曾是先民们赖以生存的技能,如今成了对人类极限的更彻底超越。

在极寒、极冷的条件下,完成空中翻腾、转体、落地,加速、超越、冲刺等一系列高难度动作,在雪地上空和光滑冰面画出一道道优美弧线——这便是冰雪运动魅力。

刚刚闭幕的2022年北京冬奥会,让我们认识了谷爱凌、苏翊鸣这样的体育新生代,让武大靖、徐梦桃、隋韩组合这些老将的名字变得广为人知,同时,也让更多「普通人」爱上了冰雪体育。

但是,对于大多数人来说,观赛的过程除了高呼一声「牛X」, 还有更多的时刻其实都是「问号脸」——什么是1620?什么是bFFF?什么是540抓板?——这些花样百出的项目技巧名称从解说员的嘴里传到我们耳边,就好像被消了音,刚想仔细看看运动员炫酷的空中动作,他们就已经在高速状态下落地。最后,留在脑子里的唯一信息,只有XXX拿了冠军。

虽然冰雪赛事的观赏性很强,「看不懂」比赛却又令很多人对它的拒之门外。为此,在今年的冬奥会期间,百度智能云用一套「3D+AI」的组合技术搞定了这个难题。

「时空定格术」. 冠军的「大招」轻松get

通过对同一个物体进行多次拍摄,或者把多个不同物体拍摄在同一画面,形成对象的有机合成,在摄影摄像中,这被称为「多次曝光」。参照这一手法,百度呈现了一种全新的特技效果——叫做「时间切片」。

冰雪项目的得分高低往往取决于动作难度、速度和稳度,而在高速状态下,不只是大众,哪怕专业的冰雪爱好者也很难凭借肉眼看清其中的技术细节。而为了看清,就要进行「时空定格」。但另一个问题是,在体育比赛中,运动员的生物信息不允许被采集。

针对这些问题,百度智能云采用了「3D+AI」双管齐下的技术路线——先做轮廓识别,由AI学习处理,然后进行三维恢复和虚拟叠加呈现。

更形象来说,这就像是一个3D版的「频闪照相机」,可以通过多次频闪捕捉高速且连续的运动轨迹,然后把时序动作定格到360度的3D空间。再配上专业解说的技术分解,观众就可以非常直观、全面地看懂选手的每一个动作细节和得扣分点,真正get到谷爱凌的1620到底有多飒。

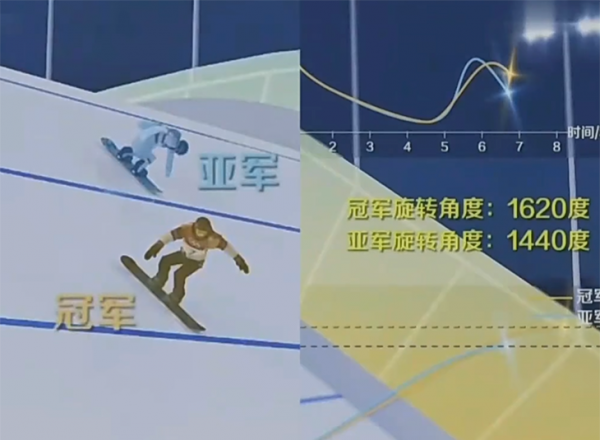

与此同时,基于「3D+AI」打造的「同场竞技」系统还能把不同选手的时序动作放到同一个画面中,把单人赛事直接变成「多人比赛」,孰优孰劣,也显而易见。

而对于置身其中的运动员来说,当所有动作都被量化,滑行速度、腾空高度、落地远度、旋转角度等一系列运动数据和原始画面叠加起来,就可以反复回看视频的动作还原,以便及时发现技巧问题,并在赛后不断完善动作细节。

可靠的技术呈现必然依赖于长期的技术积累。冰雪竞技讲求「快、稳、准、美、难」,这要求捕捉运动员画面的「摄像机系统」更聪明、更快捷——比如,需要计算机对运动员比赛动作成千上万次的学习,才能把人和滑雪板的轮廓精准识别出来;需要高效的信息处理能力,才能保持在平均15秒内把相关数据快速提取出来,以适应比赛直播的快节奏——虽然技术难度不低,但百度智能云算是提交了一份漂亮的答卷。

即便是在疫情影响下,很多观众无法亲临今年的冬奥会现场,但是,借助于百度智能云的这一套「大动作」,观众们的远程观赛体验一点也没有「减分」。

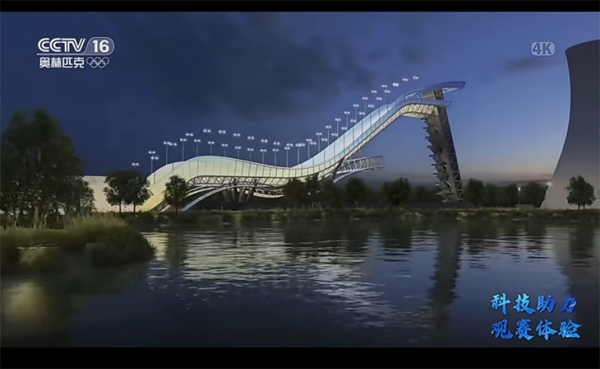

据了解,除了对运动员进行「虚拟化」,为了给观众带来极致沉浸式的「现场感」,百度智能云还利用虚拟现实技术对首钢大跳台进行了三维重建和虚拟还原,打造除了1:1的场馆3D 模型。

通过3D场景漫游的形式,观众可以从远景、全景、近景等多角度自由视角观赏大跳台,并且,还可以切换日景、夜景、水景等不同的视觉效果,周围环境、跳台弧度、赛道难度通通一览无余。

「AI手语主播」. 残障人士打开冬奥的专享方式

当我们漫游于这样一个特别的「虚拟赛场」时,还有2700多万的听障同胞也在透过百度的「黑科技」领略着极限运动之美。

北京冬奥会期间,同样由百度智能云打造的AI手语主播,在央视新闻正式「上岗」,提供24小时不间断的手语服务。这给观赛体验提供了另一种打开方式,让听障人士也能融入感受冬奥的「速度与激情」,「看懂」体育赛事。

据了解,虽然现在很多赛事转播都有字幕,但是由于听觉与文字学习具有关联性,很多听障人士常常伴随着文字阅读障碍,手语对他们而言是更共情的语言表达。然而,相较于庞大的听障人群,国内具有专业手语翻译资格的人员却非常稀少。

数字人的出现,正在填补这样的缺口。只不过在这个过程中,还有很多技术难题需要克服。比如,和日常的文本转换、文本语音转换不同,手语数字人需要经过从语音到文本、从文本到手语符号、再到数字人动作转换的漫长「养成」过程,才能蜕变出「听得清、会翻译、会表达」三大能力。这三个能力,在技术细节上分别对应着三类AI模型——

其一,ASR语音识别模型技术,它解决的是「听得清」的问题。据说基于这一模型,百度AI手语主播的翻译准确性能达到98%以上,并且无论是中英文混杂、生僻字还是方言,她都能搞定。在此前网上流传的一个视频中,百度AI手语主播就与央视段子手朱广权「同台」,面对专业人士的神级语速,她完全轻松「拿捏」;

其二,手语翻译模型,它解决的是「会翻译」的问题,而且是精准的信息凝练和低时延的翻译效果。据说为了做到足够的精准和精简,百度团队坚持选择了「自然手语语料」,并联手天津理工大学请来了上百位听障学生对语料进行数据标注,从而保障算法背后的数据的高质量和可靠性。在此基础上,再结合百度积累多年的神经网络翻译技术,团队设计了从中文文本到手语符号的翻译方法,并对模型进行了反复训练,在不到两个月时间里,进行了6次大版本迭代,最终使得手语翻译的可懂度达到了85%以上;

其三,动作生成模型,它解决的是「会表达」的问题,即关于手势、口型和表情的塑造。拿手势问题来说,百度运用了人体动作的视觉识别技术,也就是通过机器学习手语视频,再由二维骨骼点转化驱动三维数字人的动作表达。而在口型和表情方面,百度智能云则首创了4D扫描数据进行训练的方法,通过对超10万个全身多边形面、超1万个脸部面、超240个面部表情行变基、超100个身体骨骼节点的扫描,不仅能让数字人做出微笑、开心笑、甚至是wink、白眼等表情,口型生成的准确度还超过了98.5%。

「AI训练系统」. 「梦之队」背后的「神秘人」

事实上,这并不是百度的「黑科技」第一次应用在体育赛场,或者更确切来说,这并不是它第一次出现在奥运赛场。

早在去年的东京夏季奥运会期间,百度智能云就已经大显身手,为我们的跳水「梦之队」量身定制了一套「3D+AI」跳水辅助训练系统。

跳水和冰雪项目由很多共同之处,比如速度快、技巧复杂等等。运动员从起跳到落水,一般只有短短的2秒钟,甚至更短。所以,在传统训练过程中,教练帮运动员抠动作细节必须要「眼力惊人」。

为此,百度智能云为中国跳水队的赛前训练打造了国内首个「云-边-端」软硬一体的 AI 辅助训练系统。通过摄像机采集跳水画面,然后利用三维视觉技术和AI分析,对训练视频进行摘要、动作抽取、姿势纠正等处理,快速归纳整理——如此一来,就可以把运动员几秒钟内的复杂动作,进行精准的量化评估,并比照完美动作智能打分,直观地呈现给教练和运动员。

和肉眼相比,这个系统就像是一个「火眼金睛」+「最强大脑」。高速摄像机一秒钟能拍几万张照片,而且能360度全方位采集画面,3秒钟内立即反馈给教练,从而提高运动员的训练效率和效果。并且,即使在教练员出差的情况下,也能在线看到现场训练情况,远程给运动员抠细节,不错过每一次训练指导。

据了解,该系统在经过大量的数据分析后,将把教练和运动员的专业技能数字化,实现经验的分享和复用,不仅能推广到省队、市队,甚至还能普及给普通的体育爱好者,让更多人享受到国家队教练的专业指导。

跳水队之外,我国的另一个「梦之队」也很快加入了AI训练之列。在去年年底刚刚举行的百度Create2021大会上,前国家乒乓球领队姚振绪、北京大学体育教研部副主任吴飞分享了与百度合作的「人工智能乒乓球动作定位与行为识别研究项目」。

在这个项目中,AI解决的是乒乓球动作速度快、隐蔽性强、回合数多的问题。过去,所有数据都只能由人工手动记录和统计,非常耗费精力。而利用AI进行大数据处理、智能分析、辅助决策,既可以提高效率,还能通过直观的数据展现,为队员的科学训练提供依据。

据了解,这套智能乒乓系统通过超500GB 比赛的标准训练数据集,目前已经可以识别出是否发球、拉、摆短等8个大类动作。其中起止回合准确率超过97%,动作识别也超过了80%。重点解决了队员日常统计训练数据和优化比赛裁决的问题。

「科技体育觉醒」. 故事刚刚开始

伴随着「大雪花」中心的生活缓缓熄灭,北京冬奥会完美落下帷幕。在半个月的时间里,我们或许都深有感触——体育赛事比任何时候都与科技走得更近。

转而又想起2月初,在北京冬奥会正式开幕前的圣火传递阶段,有一个特别的「火炬手」——它在全世界的见证下,沿着动力东街、五一剧场路、群明湖大街、五一剧场南路环绕了一圈,完成了火炬传递的任务——它不是人类,而是来自百度的Apollo 的汽车机器人。

作为一个缩影,这位「汽车人」的出现,预告式地向世界展示了北京冬奥会的「科技冬奥」理念。在之后的奥运比赛时间里,全世界接连不断地见证着科技体育的觉醒。

其中,百度的一系列「黑科技」是无疑是抢眼的;与此同时,我们也相信,在体育赛场内外,百度的故事还会继续书写。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功